Sage

综合介绍

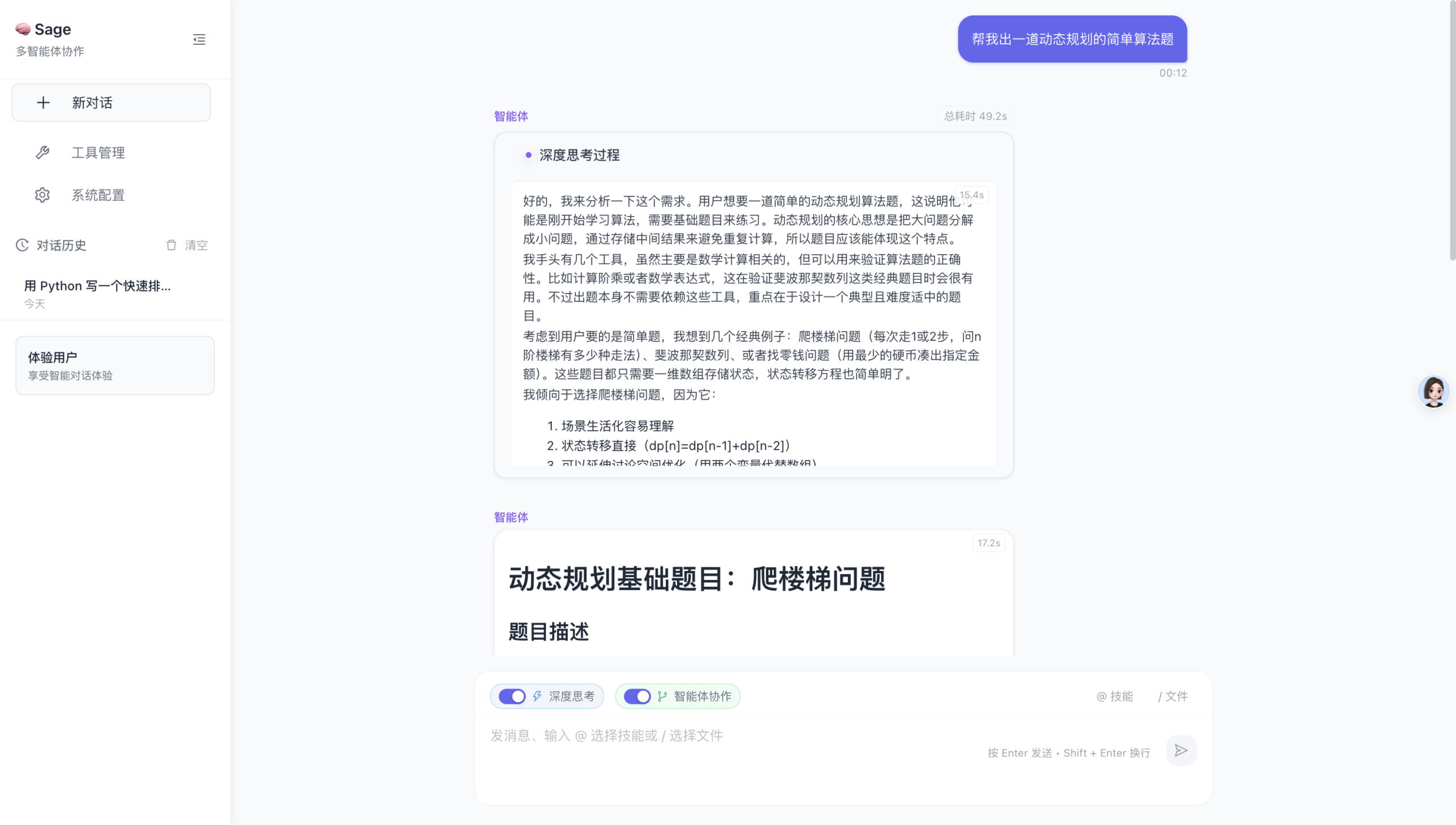

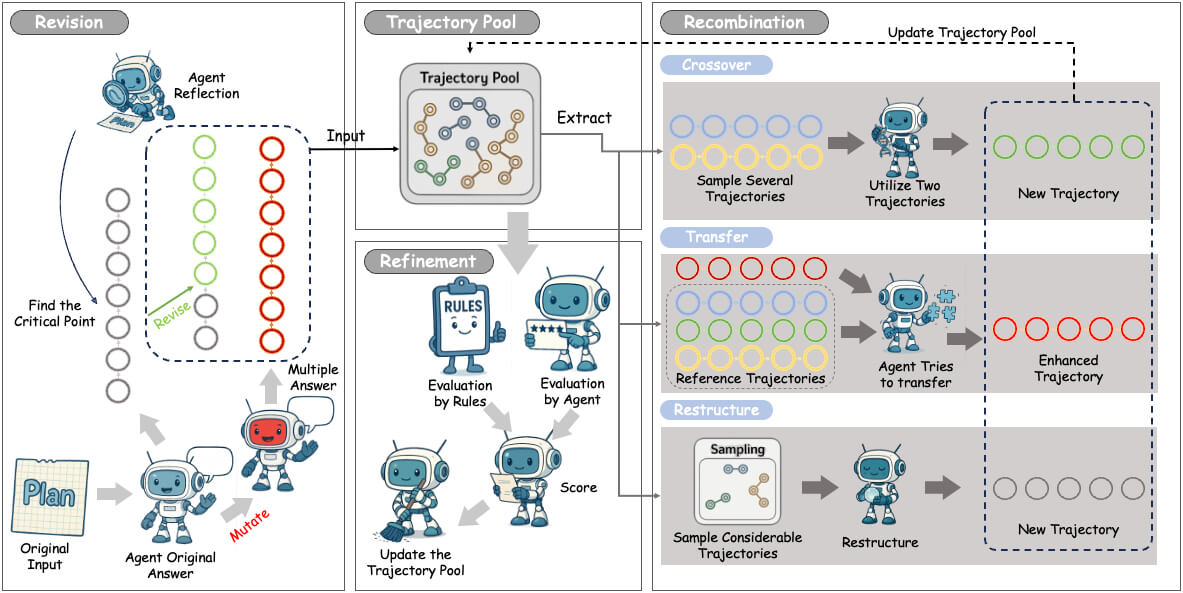

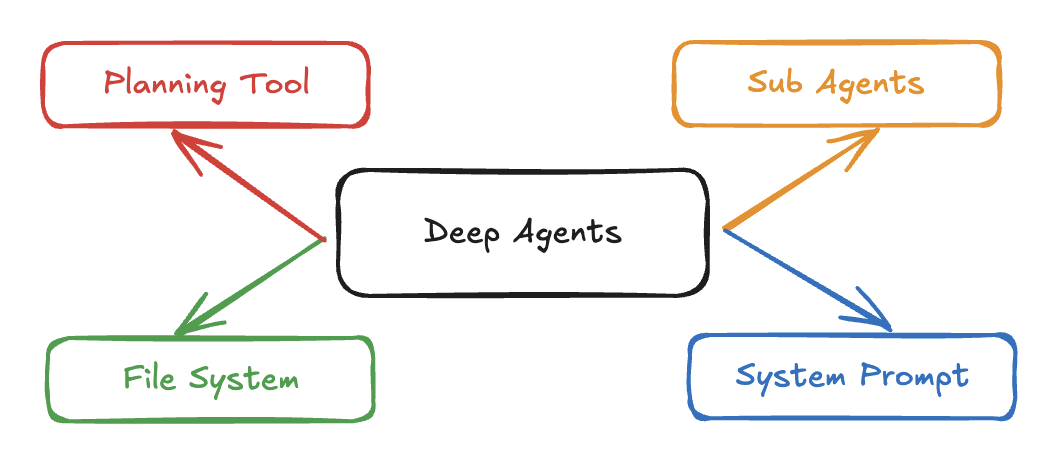

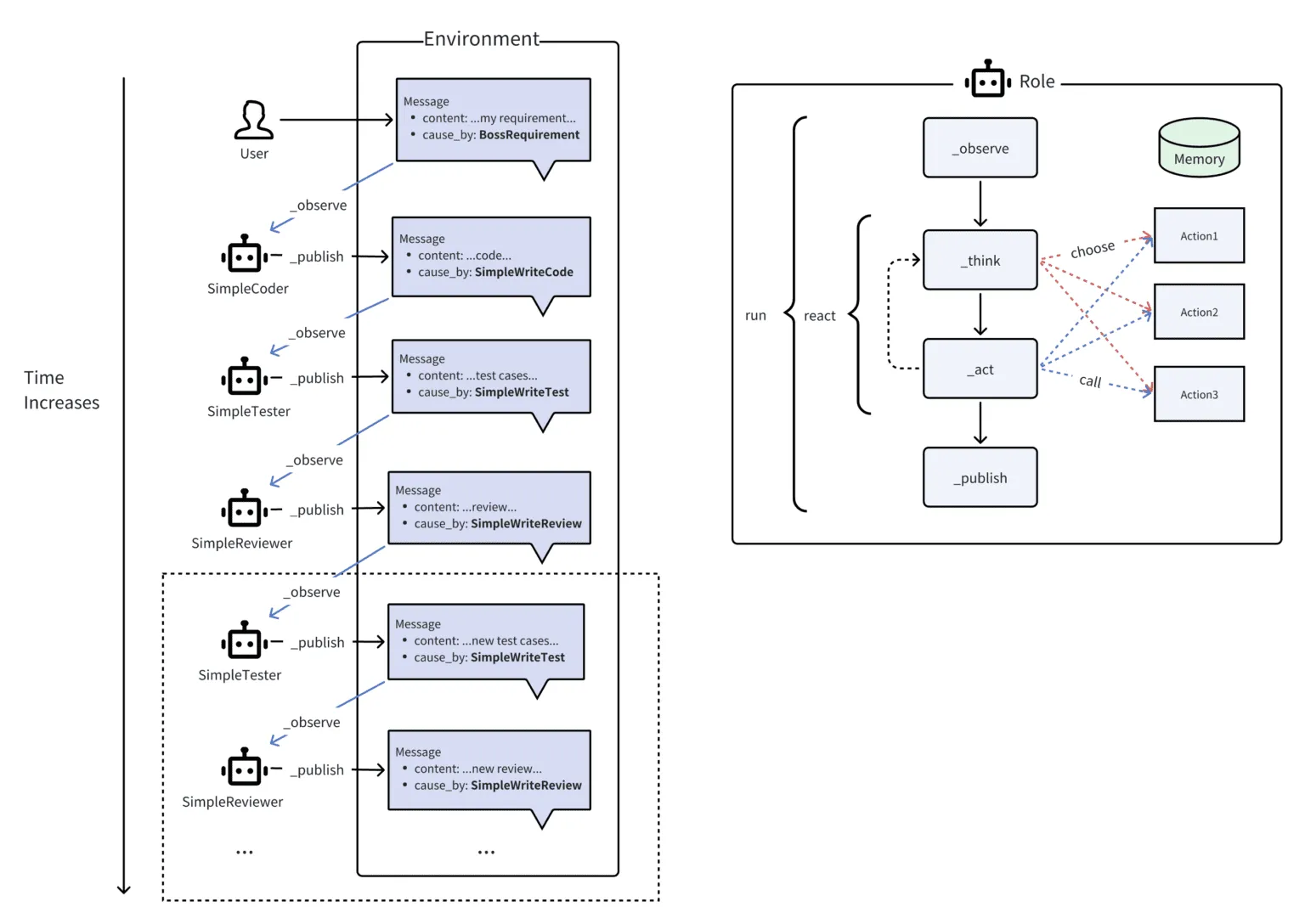

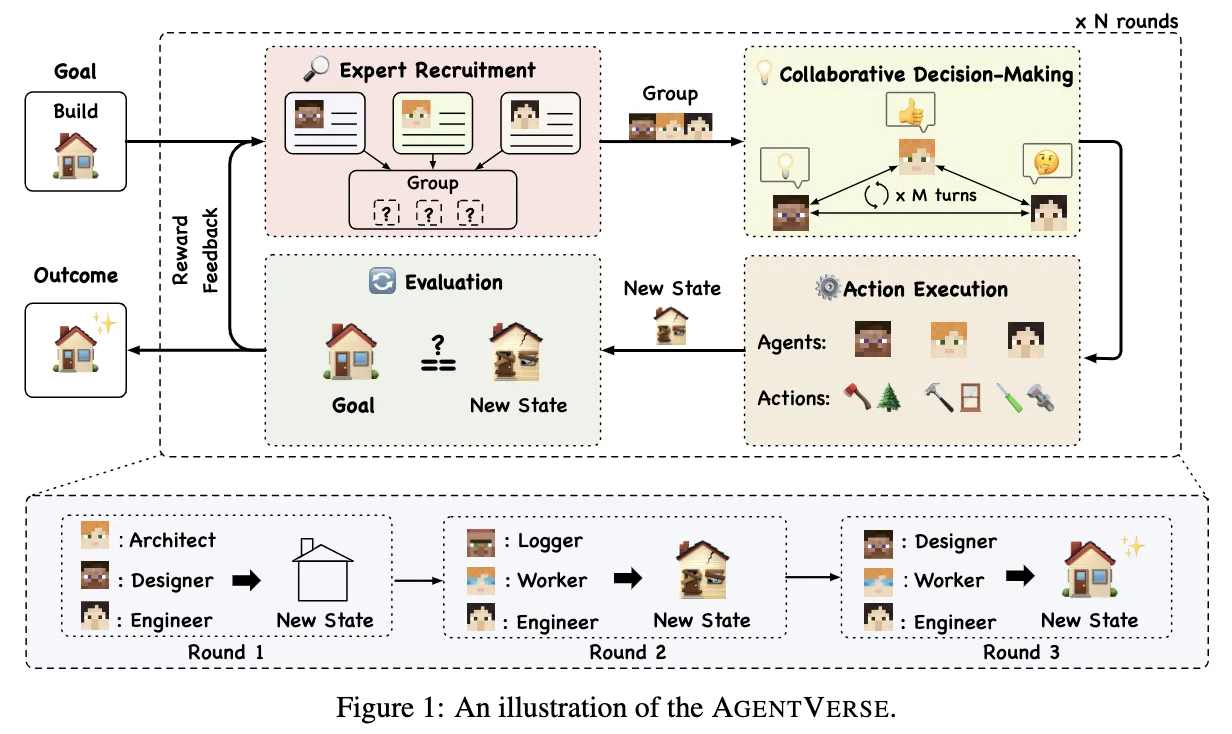

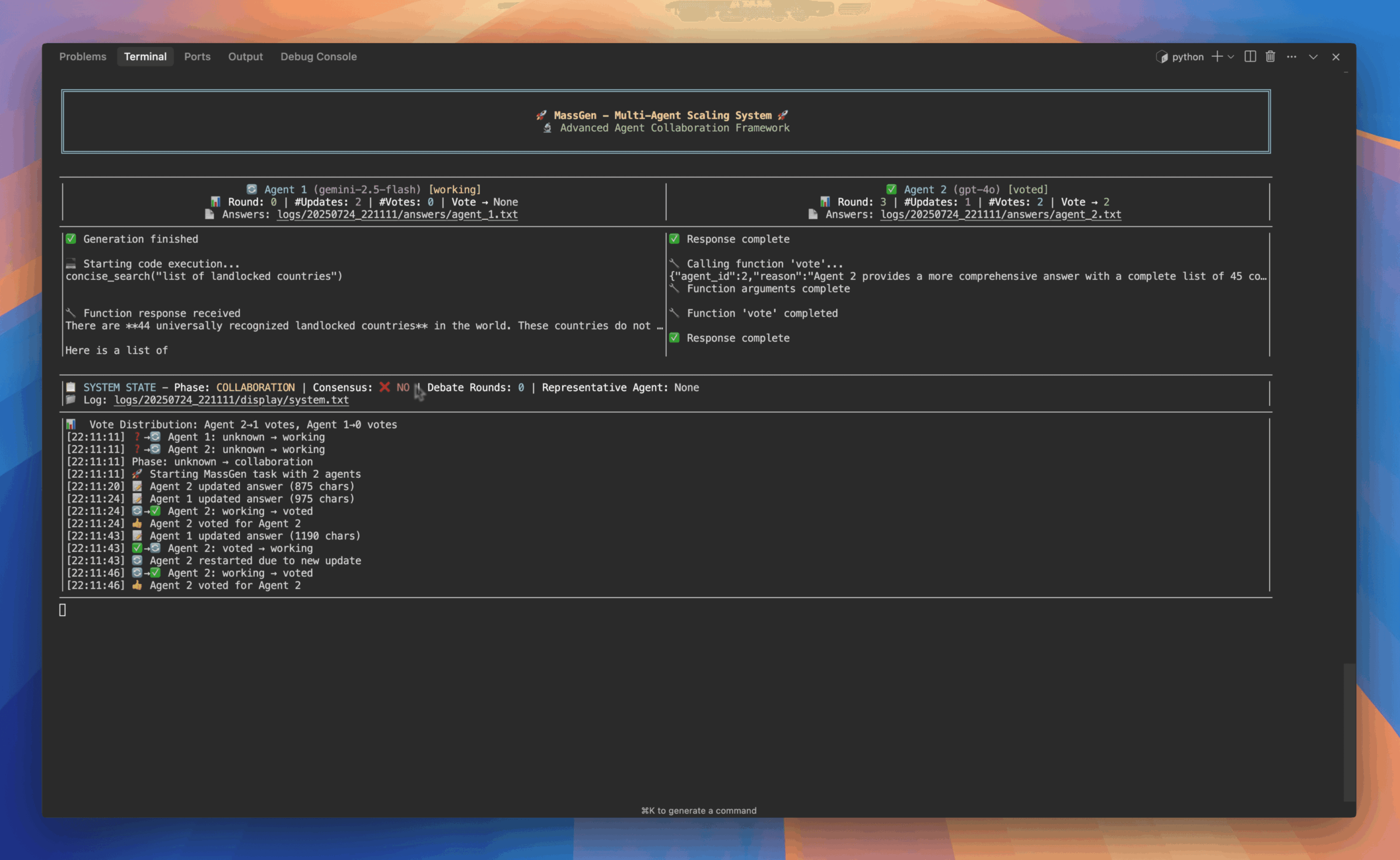

Sage 是一个为解决复杂问题而设计的多智能体编排框架。它的核心设计理念是将一个庞大而复杂的任务,通过智能化的方式拆解成多个可以管理的子任务,并指挥、协调多个专业的AI智能体无缝协作来完成。这个框架在设计上充分考虑了企业级应用的需求,因此具备生产环境开箱即用的可靠性和高度的模块化扩展能力。Sage 提供了两种核心运行模式:“深度研究模式”可以进行全面细致的分析,“快速执行模式”则专注于快速完成任务。该项目不仅提供了强大的后端能力,还配备了一个基于React和FastAPI的现代化Web交互界面,让用户可以实时、可视化地管理和监控整个任务流程。

功能列表

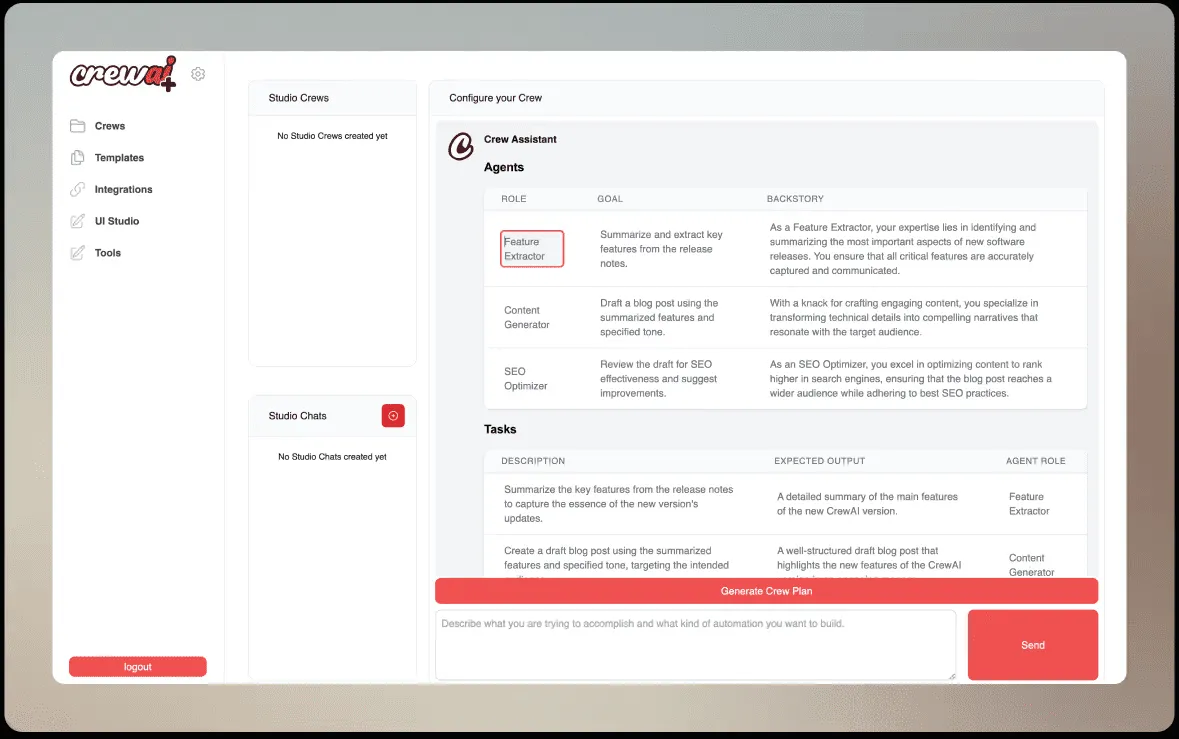

- 智能任务分解: 能自动将复杂问题分解为有依赖关系的可管理子任务,并支持并行执行规划。

- 智能体协同指挥: 实现专业化智能体之间的无缝协调,并配有强大的错误处理、重试和恢复机制。

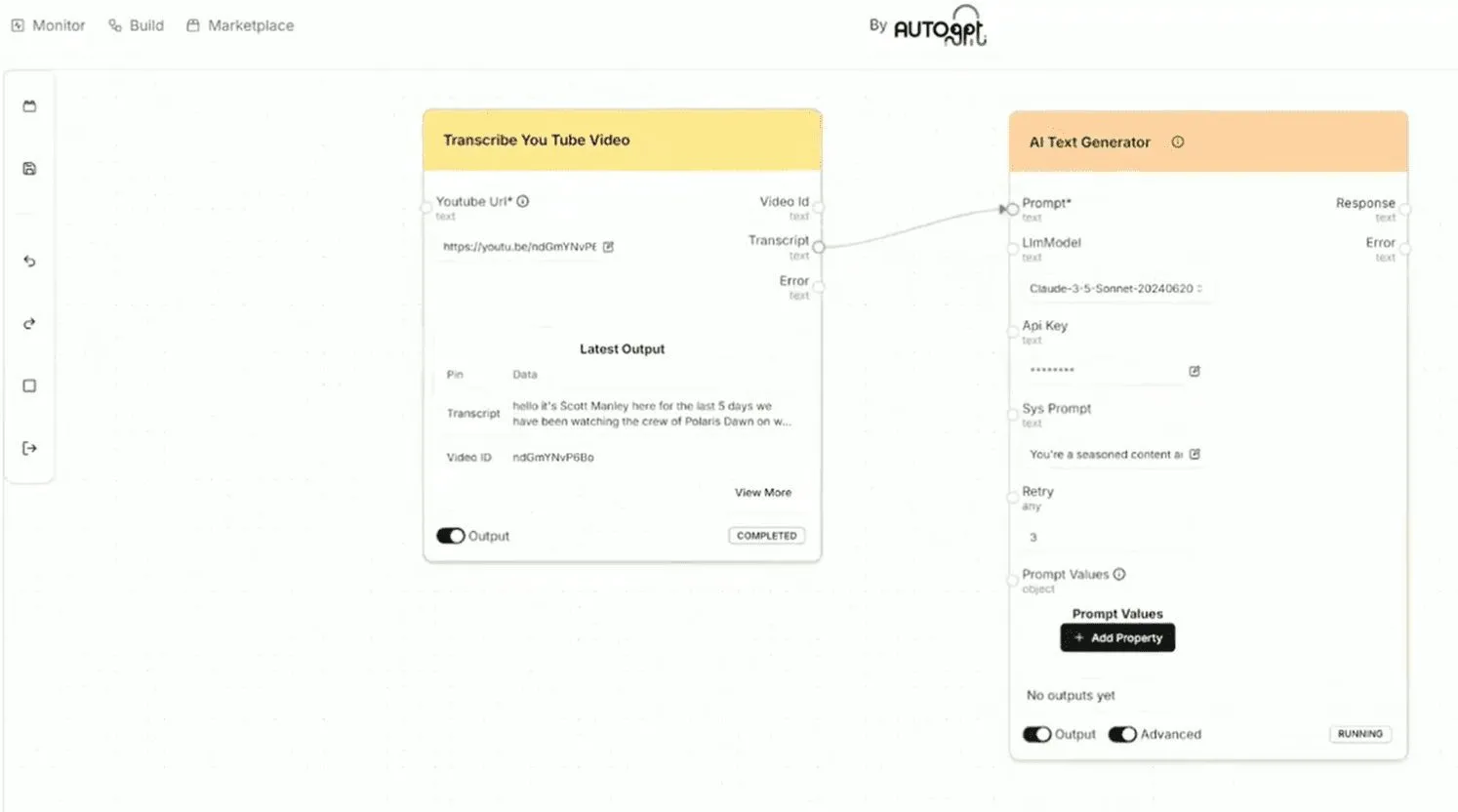

- 可扩展的工具系统: 采用热重载的插件式架构,支持通过

MCP(模型上下文协议)与远程API集成,并能自动发现和注册新工具。 - 双执行模式: 用户可以根据需求选择用于全面分析的“深度研究模式”,或用于快速完成任务的“快速执行模式”。

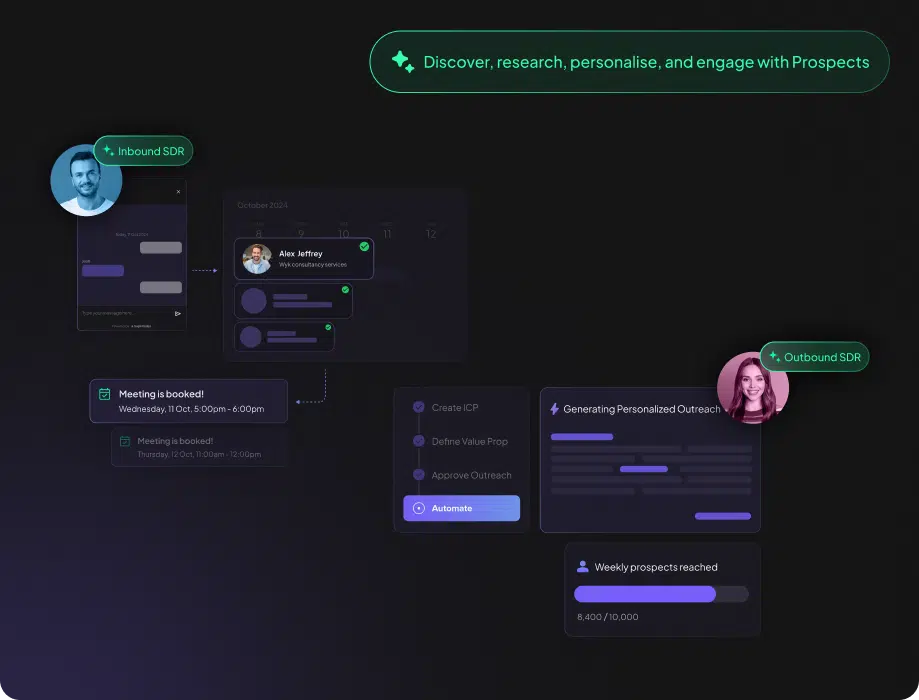

- 交互式Web界面: 提供基于React和FastAPI构建的现代化用户界面,可以实时可视化展示任务流程,并支持响应中断。

- 先进的Token追踪与优化:

- Message Manager: 通过智能过滤和压缩策略,可将Token用量减少30-70%。

- 成本监控: 全面统计和监控所有智能体的Token使用情况和相关成本,并可导出为CSV或JSON格式。

- 自定义工作流引擎: 提供一个可视化的拖拽式心智导图编辑器,用户可以轻松创建、编辑、管理和分享自定义工作流。

- 规则偏好系统: 允许用户配置AI助手的行为,例如代码风格偏好、回应语言、内容详细程度等。

- 全面的状态管理:

- Task Manager: 结构化地管理任务的完整生命周期,包括状态持久化和依赖关系追踪。

- 开发者友好: 提供简洁的API、全面的文档、丰富的示例和广泛的错误处理机制。

- 生产环境开箱即用: 具备强大的错误恢复、日志记录、重试机制和性能优化,可直接用于生产环境。

- 文件查看与管理: Web界面内置文件查看器,无需下载即可直接预览工作区文件内容。

使用帮助

Sage框架的安装和使用过程非常直接。对于非开发者用户,可以通过官方提供的在线演示地址直接体验;对于开发者,可以按照以下步骤在本地部署。

1. 在线体验(推荐)

您可以直接访问官方提供的实时演示网站,体验全部功能,无需任何本地配置。

- 官方演示地址: http://36.133.44.114:20040/

2. 本地安装流程

如果您希望在自己的设备上运行Sage,请遵循以下步骤。

第一步:克隆代码仓库打开您的终端(命令行工具),使用git命令克隆Sage的官方仓库。

git clone https://github.com/ZHangZHengEric/Sage.git

第二步:进入项目目录克隆完成后,进入项目的主目录。

cd Sage

第三步:安装核心依赖Sage的核心功能依赖于一些Python库,这些库定义在requirements.txt文件中。使用pip可以一键安装。

pip install -r requirements.txt

第四步:安装Web演示依赖(可选)如果您想在本地运行Sage提供的交互式Web界面,还需要安装用于运行Web应用的额外依赖。

pip install -r examples/fastapi_react_demo/requirements.txt

完成以上步骤后,Sage框架就已经成功安装在您的本地计算机上。

3. 启动交互式Web演示

Sage提供了一个基于FastAPI(后端)和React(前端)的现代化Web应用,让用户可以通过图形化界面与智能体互动。

如何启动:关于如何启动本地Web应用的详细说明,请参考fastapi_react_demo目录下的README.md文件。通常,这会涉及运行一个Python脚本来启动后端服务器。启动后,在浏览器中打开 http://localhost:8080 即可访问本地部署的Web界面。

Web界面核心功能:

- 多智能体协作可视化: 以流程图的形式实时展示任务的分解、规划、执行、观察和总结的全过程。

- 深度思考模式: 可以展开每个智能体的“思考气泡”,查看其详细的推理过程和决策逻辑。

- 自定义工作流管理: 提供一个可视化的心智导图编辑器,让您可以创建、编辑、管理自己的工作流程。支持节点的拖拽、缩放和平移。

- 响应中断: 在任何时候,您都可以通过点击停止按钮来中断AI的响应,系统会进行平稳的取消处理,并保留已完成的部分结果。

- 规则偏好设置: 您可以根据个人需求,配置AI的行为偏好,例如让它使用特定的语言或代码风格进行回复。

- 实时监控: 实时查看各个模型产生的Token用量、成本估算和任务执行进度。

- 文件管理: 直接在界面侧边栏查看和预览工作区生成的文件,无需下载。

4. 命令行使用与执行模式

对于开发者而言,直接在命令行中使用Sage也是一种高效的方式。您可以根据任务的复杂度和对速度的要求,选择不同的执行模式:

- 深度研究模式 (

Deep Research Mode): 这是最全面的模式,会完整执行分析、规划、执行、观察和总结的全部流程。适用于需要深度分析的复杂任务。 - 标准执行模式 (

Standard Execution Mode): 该模式会跳过详细的任务分解阶段,在性能和分析深度之间取得平衡。 - 快速执行模式 (

Rapid Execution Mode): 该模式会跳过任务分析和分解,直接开始执行,以最快的速度完成目标明确的任务。

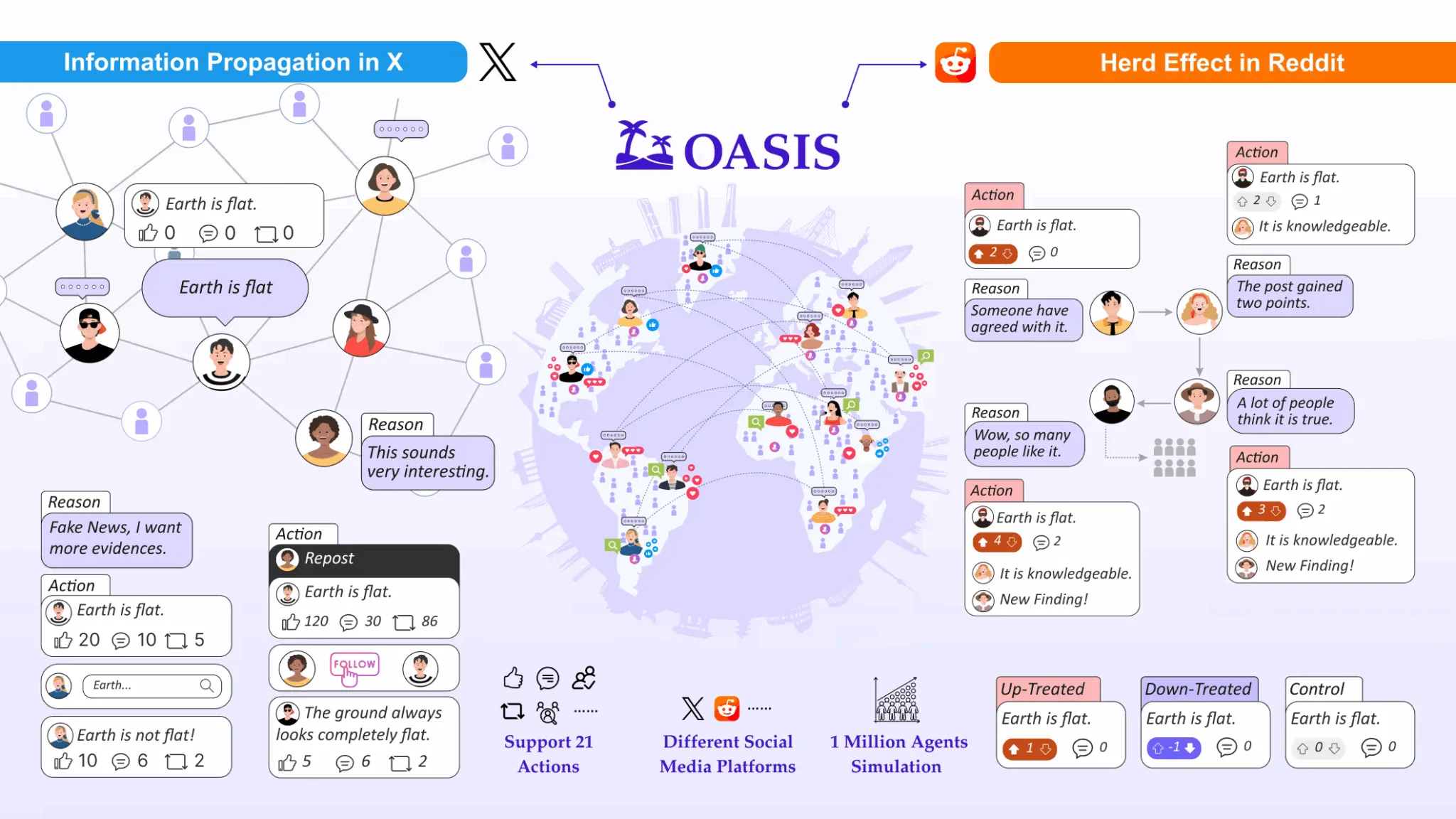

应用场景

- 自动化研究报告当需要针对某个领域或主题进行深入研究时,用户可以输入一个复杂的研究课题,例如“分析2024年全球半导体市场趋势”。Sage会启动“深度研究模式”,智能体协同工作,自动完成数据搜集、市场分析、关键厂商研究、未来趋势预测等子任务,最后由总结智能体将所有信息整合成一篇结构完整、内容详实的研究报告。

- 软件产品开发在软件开发流程中,Sage可以辅助整个开发周期。例如,一个产品经理可以提出需求:“开发一个支持多语言翻译的在线聊天应用”。Sage可以将其分解为UI/UX设计、前端开发、后端API开发、数据库设计、多语言翻译API集成等任务。不同的智能体可以分别负责生成代码草稿、设计数据库结构、编写API文档等,从而大大提升开发团队的协作效率。

- 内容创作对于内容创作者,Sage可以作为一个强大的创作助手。假设你需要为一个新产品撰写一系列营销文案,包括博客文章、社交媒体推文和视频脚本。你只需输入产品信息和目标受众,Sage的工作流就可以自动规划内容结构,然后由不同的智能体分工合作,分别生成初稿,并最终由总结智能体润色和统一风格,形成一套完整的营销材料。

QA

- Sage框架支持哪些大型语言模型(LLM)?Sage框架经过了广泛测试,官方明确支持的模型包括 DeepSeek-V3, Qwen-3, GPT-4.1 和 Claude-3.5 Sonnet。同时,它也兼容所有提供OpenAI兼容API的供应商,如OpenRouter、Anthropic、Google AI和Mistral AI等,为用户提供了极大的模型选择灵活性。

- Sage的“自定义工作流引擎”是做什么用的?这是一个核心功能,它允许用户通过一个可视化的拖拽式编辑器来设计自己的任务处理流程。您可以像画思维导图一样,定义任务的主要步骤和子步骤,并将这个流程模板保存下来。当有类似任务时,可以直接调用此模板,让AI智能体严格按照您设计的流程来执行,确保了结果的稳定性和一致性。

- 使用Sage会产生哪些费用?Sage框架本身是开源且免费的。主要费用来自于运行过程中调用第三方大型语言模型(LLM)的API所产生的Token消耗。不过,Sage内置了强大的 Message Manager,通过智能过滤和压缩技术,可以自动将Token消耗降低30-70%。同时,系统提供实时的成本监控功能,帮助您清晰地了解每一笔开销,有效控制成本。

- 我不是开发者,可以使用Sage吗?完全可以。Sage提供了一个功能完整且用户友好的交互式Web界面。您无需编写任何代码,就可以通过点击和输入来使用它的强大功能。您可以通过这个界面创建和管理工作流,与AI智能体进行聊天互动,并实时监控任务的执行全过程。您可以直接访问官方提供的在线演示进行体验。

- 什么是MCP服务器支持?MCP(Model Context Protocol)是一种标准化的协议,Sage支持通过该协议与外部工具或服务进行集成。这意味着您可以将一个远程的API服务(例如一个天气查询服务、一个数据库接口等)作为一个工具接入到Sage中。智能体在执行任务时,可以像调用本地函数一样调用这些远程服务,这极大地扩展了Sage可以使用的工具范围和能力。